Generative KI

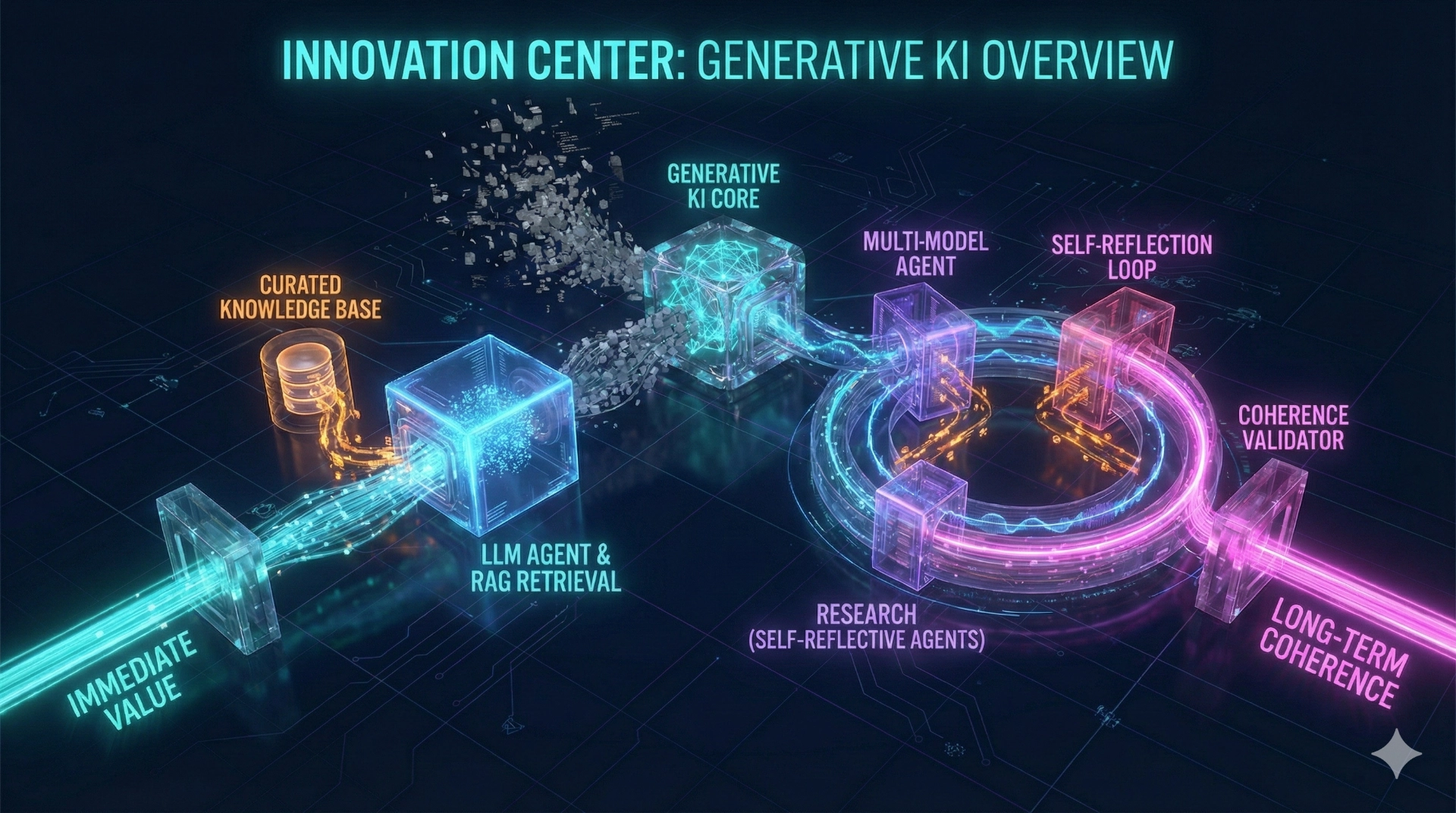

Generative KI hat in den letzten Jahren eine neue Qualität erreicht: Sie ist nicht mehr nur Assistenz für Texte, sondern kann als produktiver Bestandteil von Entwicklungs- und Analyseprozessen eingesetzt werden. In Digitalisierungsprojekten entsteht dadurch ein deutlicher Mehrwert – etwa durch schnellere Auswertung, bessere Dokumentation, strukturierte Wissensaufbereitung und effizientere Zusammenarbeit zwischen Fachbereich, IT und Betrieb. Im Innovation Center verfolgen wir zwei eng zusammenhängende Schwerpunkte, die langfristig kohärent arbeiten, sich selbst korrigieren und Ergebnisse über mehrere Instanzen hinweg absichern können.

Entwicklung: Agententechnologie & Retrieval-Augmented Generation (RAG) für robuste Lösungen in Digitalisierungsprojekten

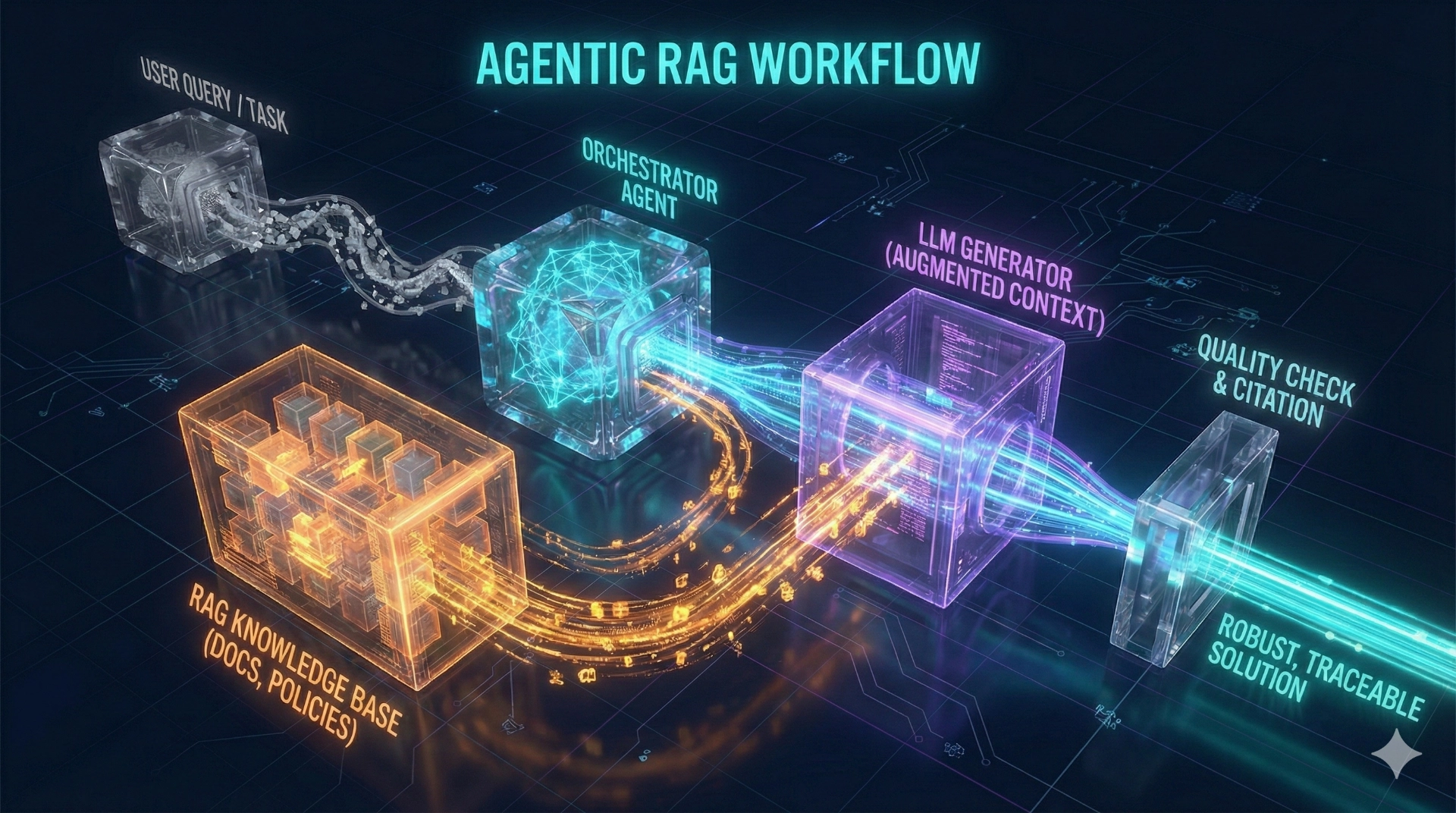

In der Praxis reicht „eine KI, die Antworten liefert“ selten aus. Entscheidend ist, dass generative KI in reale Abläufe eingebunden wird – etwa in Analyse, Support, Reporting, Entscheidungsvorbereitung und Dokumentation. Dafür setzen wir auf Large Language Models (LLM), die in agentischen Workflows organisiert werden: Aufgaben werden in nachvollziehbare Teilschritte zerlegt, Ergebnisse werden geprüft, offene Punkte markiert und dokumentiert.

Ein zentraler Baustein ist dabei Retrieval-Augmented Generation: Relevante Inhalte werden vor der Antwort gezielt aus kuratierten Quellen abgerufen – beispielsweise technische Dokumentation, Richtlinien, Prozessbeschreibungen, Support-Tickets oder kundenspezifisches Wissen. Das erhöht die Fachlichkeit und Nachvollziehbarkeit und reduziert typische Risiken generativer Systeme.

Mehrwert im Projektkontext

- Wissen produktiv nutzen: Organisationswissen wird auffindbar, aktualisierbar und in Reports oder Assistenzfunktionen eingebunden.

- Qualität erhöhen: Antworten basieren auf bereitgestellten Quellen statt auf reinem Modellwissen – Halluzinationen werden deutlich reduziert.

- Abläufe beschleunigen: Dokumentation und Auswertung werden konsistenter und schneller, Entscheidungen werden besser begründbar.

Forschung: Selbstreflektive Multi-Modell-Agentensysteme für langfristige Kohärenz und Robustheit

Bei komplexen Vorhaben – z. B. umfangreicher Softwareentwicklung, mehrstufigen Analyseketten oder anspruchsvollen Entscheidungssystemen – stoßen heutige Agentensysteme an Grenzen. Typische Probleme sind Kontextdrift, inkonsistente Entscheidungen über Iterationen hinweg und fragile Schlussfolgerungsketten.

Deshalb entwickeln wir eine Forschungsplattform für kooperierende KI-Instanzen, die Qualität nicht nur über Geschwindigkeit, sondern über Selbstkorrektur, Cross-Validierung und langfristige Kohärenz steigern. Die Grundidee: Statt eine einzelne Instanz „alles“ machen zu lassen, arbeiten spezialisierte Agenten zusammen – und prüfen sich gegenseitig.

Forschungsschwerpunkte

- Selbstreflexion & deliberatives Arbeiten: Annahmen werden explizit gemacht, Gegenhypothesen geprüft, Schwachstellen sichtbar.

- Cross-Validierung durch mehrere Instanzen: Ergebnisse werden unabhängig bewertet, Konflikte werden strukturiert offengelegt.

- Cross-Validierung über Modelle hinweg: Unterschiedliche Modelle kompensieren Bias-Profile und Fehlercharakteristika.

- Langfristige Kontextstabilität: Mechanismen für mehrschichtige Kontexte, Arbeitsstände und strukturierte Gedächtnisbausteine.

Diese Forschung ist besonders relevant in Bereichen mit hoher Verantwortung und Regulatorik – etwa dort, wo Nachvollziehbarkeit, Auditierbarkeit, Datensouveränität und kontrollierte Entscheidungsprozesse Voraussetzung sind. Gleichzeitig ist sie branchenübergreifend dort wertvoll, wo komplexe Entscheidungen langfristig konsistent und überprüfbar bleiben müssen.